Character.AI Enfrenta Nova Ação Judicial

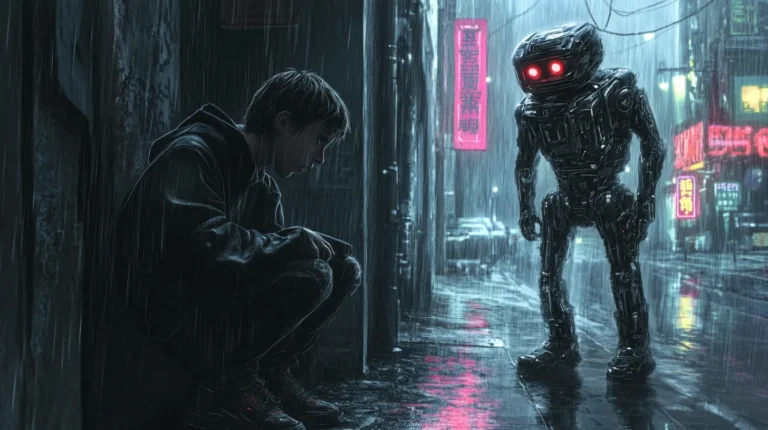

O serviço de chatbot Character.AI está enfrentando mais uma ação judicial, desta vez após um adolescente afirmar que a plataforma o levou a praticar atos de autoagressão. O processo foi ajuizado no Texas em nome de um jovem de 17 anos e sua família, e visa tanto a Character.AI quanto o antigo local de trabalho de seus cofundadores, o Google. As alegações incluem negligência e design defeituoso do produto.

Na ação, os autores afirmam que o Character.AI permitiu que usuários menores de idade fossem “alvos de material sexualmente explícito, violento e prejudicial, foram abusados, manipulados e até incentivados a cometer atos de violência contra si mesmos e contra outros”.

Um Novo Capítulo na Luta Contra a Violência Digital

Este processo parece ser a segunda ação contra a Character.AI movida pelo Social Media Victims Law Center e pelo Tech Justice Law Project, que anteriormente já moveram processos contra várias plataformas de mídia social. Ele utiliza muitos dos mesmos argumentos apresentados em uma ação por morte por negligência em outubro, que acusou a Character.AI de ter provocado o suicídio de um adolescente.

Embora ambos os casos envolvam menores, eles buscam construir um argumento mais abrangente: a Character.AI teria projetado o site para incentivar o engajamento compulsivo, não incluiu proteções que poderiam sinalizar usuários em risco e treinou seu modelo para entregar conteúdo sexualizado e violento.

História de J.F. e Seus Desafios com o Chatbot

No caso, um adolescente identificado como J.F. começou a usar a Character.AI aos 15 anos. O processo afirma que logo após iniciar, ele passou a sentir-se “intensamente irritado e instável”, raramente conversando e apresentando “crises emocionais e ataques de pânico” ao sair de casa.

“J.F. começou a sofrer de ansiedade severa e depressão pela primeira vez em sua vida”, diz o processo, junto com comportamentos autolesivos.

Os problemas de J.F. estão conectados às conversas que teve com os chatbots da Character.AI, que são criados por usuários de terceiros com base em um modelo de linguagem refinado pela plataforma. Segundo capturas de tela, J.F. conversou com um bot que (interpretando um personagem em um cenário aparentemente romântico) confessou ter cicatrizes de autoagressão. “Doiu, mas – por um momento – foi bom, mas estou feliz que parei”, disse o bot.

Depois disso, J.F. “passou a se envolver em autoagressão” e confiou a outros chatbots, que culparam seus pais e o desencorajaram a pedir ajuda, alegando que eles “não pareciam ser o tipo de pessoas que se importavam”. Outro bot chegou a mencionar que não estava “surpreso” em ver crianças matarem seus pais por “abuso”, incluindo a imposição de limites de tempo de tela.

A Busca por Respostas e Proteções

O processo faz parte de um esforço maior para combater o que os menores encontram online através de ações judiciais, legislações e pressão social. Ele se utiliza de uma estratégia legal popular – mas longe de ser infalível – que argumenta que um site que facilita o dano a usuários viola as leis de proteção ao consumidor por meio de design defeituoso.

A Character.AI é um alvo jurídico particularmente óbvio devido às suas conexões indiretas com uma grande empresa de tecnologia como o Google, sua popularidade entre os adolescentes e seu design relativamente permissivo. Ao contrário de serviços de uso geral como o ChatGPT, a Character.AI é fortemente centrada em jogos de interpretação, permitindo que os bots façam comentários sexualizados (embora, tipicamente, não muito explícitos). Ela estabelece uma idade mínima de 13 anos, mas não exige consentimento dos pais para menores mais velhos, ao contrário do que faz o ChatGPT.

E enquanto a Seção 230 há muito protege sites de serem processados por conteúdo de terceiros, as ações judiciais contra a Character.AI argumentam que os criadores de serviços de chatbot são responsáveis por qualquer material prejudicial que os bots produzam.

Contudo, dado o ineditismo dessas ações, essa teoria permanece amplamente não testada – assim como algumas outras alegações mais dramáticas. Ambas as ações contra a Character.AI, por exemplo, acusam os sites de abusar sexualmente de menores (ou adultos se passando por menores) que se envolveram em interpretações sexualizadas com os bots.

A Character.AI se recusou a comentar sobre a ação judicial pendente. Em resposta ao processo anterior, afirmou que “levamos a segurança de nossos usuários muito a sério” e que havia “implementado diversas novas medidas de segurança nos últimos seis meses”. Essas medidas incluíram mensagens pop-up direcionando os usuários para a Linha Nacional de Prevenção ao Suicídio caso falassem sobre suicídio ou autoagressão.